摘 要: FT算法是在空間頻域內的顯著目標檢測算法。該算法簡單、高效,但是在自然圖像顯著目標檢測中,存在顯著區域中心像素抑制、顯著目標不突出等問題,故對FT算法進行改進。首先,在特征提取階段,除了提取顏色和亮度信息外,改進的FT算法還提取圖像的邊緣信息,利用Canny算子檢測圖像的邊緣并用梯度算子表示邊緣特征,使得顯著區域的邊界信息更加豐富;然后,利用中心優先規則線性處理顯著圖,提高顯著區域的中心像素的亮度,突出顯著區域,去除冗余信息。仿真結果表明改進的FT算法是切實可行的。

關鍵詞: 顯著目標檢測;Canny算子;梯度;中心優先

0 引言

視覺注意機制是人類視覺系統的重要機制,它能夠從復雜的圖像中準確識別顯著目標。一般來說,顯著區域包含較多的信息,顯著目標檢測被廣泛應用于許多圖像處理領域,例如感興趣區域的自適應壓縮、圖像和視頻的質量評估[1]、視頻監控[2]、圖像分割和草圖檢索等。

顯著性目標檢測源于視覺注意模型,是一種模擬人類視覺智能的重要模型,它得到圖像中最顯著的區域。大量的研究表明視覺注意模型分為兩種類型:自底向上的數據驅動的顯著性提取和自頂向下的目標驅動的顯著性提取。由于視覺內容需要大量的先驗知識,自頂向下的方法應用不多。而自底向上的方法受圖像特征支配,不依賴任何先驗知識,被廣泛研究和應用。比較經典的自底向上的視覺注意模型是Itti[3]模型,Itti是在特征整合理論的基礎上,利用高斯金字塔進行非均勻采樣得到9個尺度的圖像,計算各尺度的顏色、亮度和方向特征,由中央周邊差算子計算各尺度上的顯著圖,最后把各個尺度的顯著圖融合得到顯著圖,但是Itti算法得到的顯著圖的分辨率低,計算量較大。基于圖的顯著性算法(Graph-Based Visual Saliency,GBVS[4]),在Itti算法的基礎上進行了改進,在特征提取階段,采用Markov鏈方法計算顯著值,顯著目標相對完整。基于空間頻域分析的算法有兩種,剩余譜方法(Spectral Residual,SR[5])和全分辨率方法(FT[6])。SR算法運算效率高,并且該算法的顯著圖和人眼感知具有一致性。但是SR算法不能計算顏色的顯著度。FT算法是基于空間頻域分析的,比SR算法保留了較多的高頻信息,顯著目標的邊界比SR算法清晰,但同時也引入了噪聲。

FT算法是基于空間頻域分析的顯著算法,該算法簡單高效,但是顯著區域中心像素抑制,顯著目標不突出。故本文在提取顏色和亮度特征的基礎上,加入提取圖像的邊緣特征,提高顯著區域的輪廓信息的清晰度,得到顯著圖,最后利用中心優先規則對顯著圖做線性處理,優化顯著圖,提高顯著區域的亮度。

1 FT算法

FT算法是Achanta等在2009年提出的全頻域分析算法,利用顏色和亮度特征來估計中央周邊差對比度,疊加多個帶通濾波器得到全分辨率顯著圖。

1.1 FT算法原理

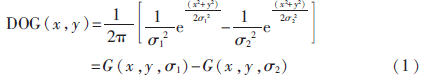

設wlc為低頻截止頻率,whc為高頻截止頻率。為了突出大的顯著對象,wlc需盡可能的低。為了得到較好的輪廓信息,whc選擇較高。本算法選擇DOG濾波器作為帶通濾波器。DOG公式如下:

式中, 1和

1和 2是高斯分布的標準差。DOG帶通濾波器的通頻帶寬是由

2是高斯分布的標準差。DOG帶通濾波器的通頻帶寬是由 1與

1與 2的比值決定的。多個DOG濾波器疊加可由濾波器的標準差的比值ρ表示:

2的比值決定的。多個DOG濾波器疊加可由濾波器的標準差的比值ρ表示:

在計算顯著圖時, 1和

1和 2的取值決定帶通濾波器保留圖像中的頻率范圍。為了使ρ變大,令

2的取值決定帶通濾波器保留圖像中的頻率范圍。為了使ρ變大,令 1為無窮大,這將在截止直流頻率的同時保留所有的其他頻率。使用一個小的高斯核去除高頻率的噪聲以及紋理。其中小的高斯核選擇二項濾波器代替。使用1/16*[1,4,6,4,1]二項濾波器,并令whc=π/2.75。

1為無窮大,這將在截止直流頻率的同時保留所有的其他頻率。使用一個小的高斯核去除高頻率的噪聲以及紋理。其中小的高斯核選擇二項濾波器代替。使用1/16*[1,4,6,4,1]二項濾波器,并令whc=π/2.75。

視覺顯著值的計算公式為:

Iu(x,y)是圖像在lab空間的像素算術平均值,Iwhc(x,y)是圖像的高斯模糊模板(使用5×5二項式濾波器),用來消除紋理細節以及噪聲,‖‖是歐式距離。

1.2 FT算法的顯著圖

根據公式(3),得出FT算法的仿真結果如圖1所示。

其中,第一列是原圖像,第二列是FT算法得到的顯著圖。從FT算法的顯著圖中看出,前兩幅圖像顯著區域弱化,背景對比度較差,顯著區域中心像素抑制,不顯著區域被突出。第三幅圖像背景簡單,顯著圖相對較好,背景冗余信息處理較好,但仍存在部分顯著區域弱化的問題。針對這些問題,利用改進的FT算法進行完善。

2 算法的改進

算法的改進分為兩個部分:首先在特征提取階段,加入了全局邊緣特征提取處理,能使顯著區域邊界更加清晰;然后利用中心優先規則對顯著圖做線性處理,解決顯著區域中心像素抑制和顯著區域不突出等問題。

2.1 基于邊緣特征提取的全局處理

FT算法在特征提取上采用的是顏色和亮度的特征,由于自然圖像內容豐富,邊緣信息比較重要,因此本文在FT算法的顏色和亮度特征提取的基礎上,加入圖像的邊緣特征,使得邊緣細節更加豐富。

由于Canny算子錯誤率低、邊緣點能較好地定位以及單一的邊緣點響應等優點,故采用Canny算子檢測圖像的邊緣信息。圖像梯度信息可以有效地表現圖像邊緣的強度和方向,故采用Sobel模板作為導數算子,計算圖像灰度沿著水平和垂直兩個方向的偏導數,進而計算出梯度的大小和方向。步驟如下:

(1)用一個高斯濾波器平滑輸入圖像。高斯函數定義為:

設輸入圖像為f(x,y),平滑后的圖像為fs(x,y),公式為:

fs(x,y)=G(x,y)*f(x,y)(5)

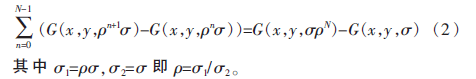

(2)邊緣提取。選擇Sobel模板計算梯度的大小。gx代表橫向檢測的圖像灰度值,gy為縱向邊緣檢測的圖像灰度值。其具體公式如下:

梯度的幅值為:

|g|=|gx|+|gy|(7)

那么公式(3)的顯著值定義更改為:

2.2 基于中心優先規則的局部處理

一般來說,圖像像素的中心分布常被用于顯著區域定位和估計,這是因為人們拍照時往往把感興趣的目標定位在圖像的中心位置。結果表明每個像素到圖像中心的距離能夠較好地預測顯著目標。根據格式塔法則,視覺形式可能具有一個或幾個中心的圖形。這表明接近注意焦點的部分被認為顯著,遠離注意焦點的部分被認為是背景。故本文提出中心優先[7]的概念,這能使顯著的邊緣更加顯著,有效地去除背景中的小補丁,更好地評估顯著圖的性能。

使用一個二維的高斯函數確定圖像的中心,定義圖像的高度為H,寬度為W,高斯函數在二維空間定義為:

圖像中任意像素點(x,y)的最終顯著值為:

S(x,y)=S′FT(x,y)G(x,y)(10)

其中G(x,y)為像素點(x,y)在中心優先圖中的像素值。

3 仿真結果分析

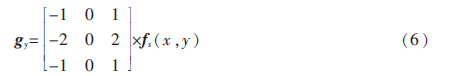

本實驗是在MATLAB 2012a平臺中實現上述算法,采用的圖像來自MSRA-1000數據庫,本數據庫包含1 000幅自然圖像和所對應的人工分割圖。FT算法和改進的FT算法的顯著圖如圖3所示。

從顯著圖的對比結果看出,改進的FT算法提取的顯著圖邊界信息豐富,顯著區域亮度提高,顯著區域中心對比度提高。該算法提取的效果更加符合生物的視覺感知,比FT算法效果好,準確度較高,顯著性更明顯。

4 結論

本文在視覺注意模型的基礎上,對FT算法進行了改進。仿真結果表明該算法在自然圖像數據庫中能夠較好地檢測顯著目標,此算法的原理是在特征提取階段,加入了邊緣特征提取處理,使得邊緣細節更加豐富,然后利用中心優先線性處理顯著圖,得到最終的顯著圖,提高了顯著區域和顯著區域中心像素的亮度,顯著目標得到了更好的檢測。改進的算法簡單、高效,明顯優于FT算法。但該算法仍存在一些不足,例如顯著目標內部的細節不明顯,仍需進一步完善。

參考文獻

[1] WANG Z, LI Q. Information content weighting for perceptual image quality assessment[J]. IEEE Trans. Image Process, 2011,20(5):1185-1198.

[2] LOPEZ M T, FERNANDEZ-CABALLERO A, FERNANDEZ M A, et al. Visual surveillance by dynamic visual attention method[J]. Pattern Recognition, 2006, 39 (11):2194-2211.

[3] ITTI L, KOCH C, NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(11):1254-1259.

[4] HAREL J, KOCH C, PERONA P. Graph-based visual saliency[J]. Neural Information Processing Systems, 2007, 19(1): 545–552.

[5] Hou Xiaodi, Zhang Liqing. Saliency detection: a spectral residual approach[C]. IEEE Conference on Computer Vision and Pattern Recognition, Shanghai, 2007:2280-2287.

[6] RADHAKRISHNA A, SHEILA H, FRANCISCO E, et al. Frequency-tuned salient region detection[C]. Los Alamitos: IEEE Computer Society Press, 2009: 1597-1604.

[7] GOFERMAN S, ZELNIK-MANOR L, TAL A. Context-aware saliency detection[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, San Francisco: IEEE Computer Society Press, 2012: 2376-2383.