王丹丹,夏斌

(上海海事大學, 上海 201306)

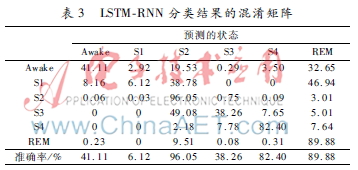

摘要:隨著模式識別技術的發展與應用,睡眠自動分期方法正在逐漸取代手動分期研究。文章使用深度置信網絡(Deep Belief Network, DBN)和長短時記憶遞歸神經網絡(Long ShortTerm Memory Recurrent Neural Network, LSTMRNN)這兩種方法對眼電(Electrooculogram, EOG)通道的數據進行睡眠自動分期。LSTMRNN方法(平均準確率83.4%)相對DBN(平均準確率75.6%)在基于眼電信號的睡眠分期問題上取得了更好的效果。

關鍵詞:DBN;LSTM-RNN;睡眠自動分期;EOG

0引言

睡眠與人的健康息息相關。充足的睡眠可以消除疲勞,保證日常生活的正常進行,但是由于生活節奏的加快和壓力的增大,現代人通常都存在不同程度的睡眠障礙。有調查顯示,成年人存在睡眠障礙的比例高達30%。睡眠障礙會導致大腦功能紊亂,對身體造成多種危害,嚴重影響身心健康。因此對睡眠狀況進行研究,了解睡眠質量,可以及早地診斷和治療隱藏疾病。睡眠分期是將睡眠過程分為不同的狀態。根據參考文獻[1],睡眠過程分為三種狀態:清醒狀態(Awake)、非眼球快速運動睡眠狀態(NonRapid Eye Movements, NREMS)和眼球快速運動睡眠狀態(Rapid Eye Movements, REMS)。其中NREMS細分為四個狀態:S1~S4,分別代表淺度睡眠、輕度睡眠、中度睡眠和深度睡眠。

睡眠分期的方法主要有兩類:一類是基于R&K準則,需要經驗豐富的專家對數據進行目測分類,這種方法不僅耗時費力,而且易受專家主觀因素影響。另一類是睡眠的自動分期方法,其用模式識別算法自動對數據提取特征和進行分類。目前使用較多的有支持向量機(Support Vector Machine, SVM)、隨機森林(Random Forest)、人工神經網絡等。

由于深度學習可以自動提取特征,通過組合低層特征形成更加抽象的高層特征[2],因此本文利用兩種深度學習網絡分別對EOG進行分期研究,并對分期結果進行比較。

1方法概述

1.1深度置信網絡

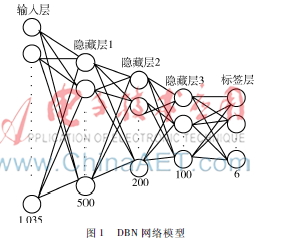

深度置信網絡(Deep Belief Network,DBN)是Hinton在2006年提出的[3]。它由一系列受限玻爾茲曼機(Restricted Boltzmann Machines, RBM)組成。DBN網絡的核心思想是將RBM堆疊在一起,訓練出權值,將這個權值作為神經網絡權值的初始值,再用經典的梯度法去訓練網絡。本文中用到的DBN結構如圖1所示。DBN網絡共有5層:輸入層、3個隱層、標簽層。隱層的單元個數分別為500、200、100。DBN的訓練過程包括三步:(1) RBM的訓練,需將數據劃分為小批量的數據,HINTON G E在參考文獻[4]中提出小批量數據的大小minibatche設置為10~100,本文中設置為60,訓練迭代次數epoch設為10。 (2)將RBM訓練得到的權重作為DBN網絡的初始值進行訓練。設置minibatche為1 000,epoch為30。(3)進行有監督微調,學習率設置為0.03。

1.2長短時記憶遞歸神經網絡

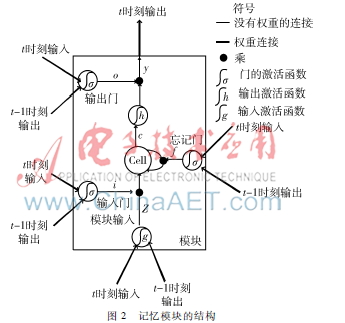

將每個受試的EOG數據看做一個序列,由于序列節點之間存在時序相關性,因此預測模型要具有記憶功能,能夠包含序列的遠距離信息。而遞歸神經網絡(Recurrent Neural Network,RNN)恰好滿足這一要求。RNN含有從單元的輸出到單元的輸入的連接(即含有遞歸連接),因此可以利用其內部的記憶來處理具有時序的輸入序列。然而,傳統的RNN存在梯度消失和梯度激增的問題,導致遠距離的信息不能有效地被利用。為了解決這一問題,HOCHREITER S和SCHMIDHUBER J在1997年提出了一種新的RNN網絡——長短時記憶遞歸神經網絡(LSTMRNN),它使用記憶模塊取代傳統RNN的隱層單元,通過記憶細胞內部狀態的自反饋和輸入輸出門對誤差的截斷,解決了梯度消失和激增的問題。LSTMRNN可以學習長度超過1 000的序列[5]。本文中使用的是具有忘記門的記憶模塊,結構如圖2所示。

LSTM層的權重的計算主要包括兩個過程:前向傳播和后向傳播。

Xt表示t時刻的輸入向量,W表示輸入權重矩陣,R表示遞歸權重矩陣,b表示偏置單元。門的激活函數σ通常指的是sigmoid函數。記憶細胞的輸入輸出激活函數(g和h)通常是tanh函數。E表示損失函數,兩個向量之間的點乘用“·”表示。

前向傳播就是依次按照順序計算模塊內部各個組成部分的輸入輸出直至得到記憶模塊的輸出。

模塊輸入:

zt=g(WzXt+Rzyt-1+bz)(1)

輸入門輸出:

it=σ(WiXt+Riyt-1+bi)(2)

忘記門輸出:

ft=σ(WfXt+Rfyt-1+bf)(3)

記憶細胞輸出:

ct=zt·it+ct-1·ft(4)

輸出門輸出:

ot=σ(WoXt+Royt-1+bo)(5)

模塊輸出:

yt=h(ct)·ot(6)

后向過程就是從最后一個時間將積累的殘差E傳遞回來。在此過程中采用的是BPTT[6](Back Propagation Through Time)算法。

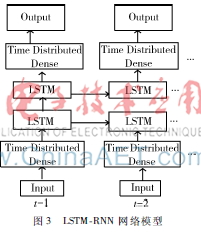

在本文中,將每30 s的數據作為一個時間步長進行輸入,輸出長度為6的向量,因此使用到LSTMRNN的網絡結構如圖3所示,其中TimeDistributedDense層是一個基于時間維度的全連接層。學習率和網絡單元個數是圖3LSTMRNN 網絡模型網絡的最重要的參數,而且各參數之間的調整可以看做是獨立的[7],因此可以獨立地對各個參數進行調優。最終參數的設置為第一層全連接層單元數為500,兩層LSTM的單元個數為200、100,最后一層全連接層與第一層全連接層單元相同但是單元數設為6,batchsize為1,迭代次數epoch為128,學習率為0.003。

2實驗數據

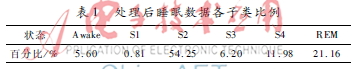

本文用到的數據是圖賓根大學采集到的9名受試者晚上的睡眠數據,他們的平均年齡為23.5歲,其中包括3名女性。在實驗前的6周,要求受試者們保持規律的作息時間并禁止喝咖啡。在本項研究中使用EOG通道,信號的采樣率是500 Hz,專家將每30 s的數據對應于一個標簽。由于本文對數據做6分類(AWAKE、S1、S2、S3、S4、REM)分析,因此只保留此6個狀態的數據。首先對數據進行預處理操作:(1)去除兩個不同狀態轉換時對應的數據,得到處理后各子類數據比例如表1所示。(2)將數據進行快速傅里葉變換,取0.5~35 Hz之間的頻域數據。(3)進行歸一化后得到用于分期的數據。表1處理后睡眠數據各子類比例狀態Awake S1S2S3S4REM百分比/%5.600.8154.256.2011.9821.16

3實驗結果

本文中使用留一驗證的方法,圖4展示了每個受試者DBN和LSTMRNN的分類結果。表2和表3展示的是兩種方法對應的混淆矩陣。通過分析結果可以得到以下結論:(1)EOG數據可以用作睡眠分期研究。(2)DBN和LSTMRNN在睡眠分期研究中都取得了較好的結果,但是LSTMRNN無論是在每個受試者的準確率還是在每個狀態的分類準確率上都要優于DBN。(3)在混淆矩陣中,S2、S4和REM的準確率比其他狀態的準確率高,這與處于S2、S4、REM狀態的數據在總數據中占得比例較高和各個狀態具有相似特征有關。

4結論

本文通過基于EOG通道的睡眠分期研究可以得出,DBN和LSTMRNN作為睡眠自動分期方法,可以很好地自動提取特征并進行分類,在處理時序序列的分類時,LSTMRNN可以更好地利用長距離信息對睡眠數據進行分期,其分類效果優于DBN。

參考文獻

[1] RECHTSCHAFFEN A,KALES A. A manual of standardized terminology,techniques and scoring system for sleep stages of human subjects[M]. Los Angeles: Brain Information Service/Brain Research Institute,1977.

[2] BENGIO Y,DELALLEAU O. On the expressive power of deep architectures[C].Proc of the 14th International Conference on Discovery Science. Berlin: SpringVerlag,2011:1836.

[3] HINTON G E,OSIJDERO S,TEH Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation,2006,18(7) :15271554.

[4] HINTON G E. A practical guide to training restricted Boltzmann machines[J].Momentum,2010, 9(1):599619.

[5] HOCHREITER S, SCHMIDHUBER J. Long shortterm memory[J].Neural Computation, 1997,9(8):17351780.

[6] GRAVES A. Supervised sequence labelling with recurrent neural networks[M]. Berlin: Springer, 2012.

[7] GREFF K, SRIVASTAVA R K,KOUTNI'K J,et al. LSTM:a search space odyssey[J/OL]. arXiv preprint. (20150313)[20160301].http://arxiv.org/abs/1503.04069.