7 月 31 日消息,來自明尼蘇達大學雙城校區的研究團隊最新研制出計算隨機存取存儲器(CRAM),可以將 AI 芯片的能耗降至千分之一。

國際能源機構 (IEA) 預測,AI 的能源消耗將翻一番,2022 年耗電量為 460 太瓦時(TWh),而在 2026 年耗電量預估將達到 1000 太瓦時。

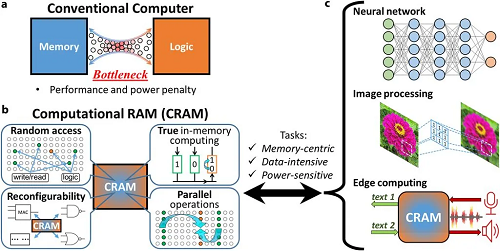

團隊表示,傳統 AI 芯片需要在邏輯(處理)和內存(存儲)之間不斷傳輸數據,因此導致耗電量巨大。

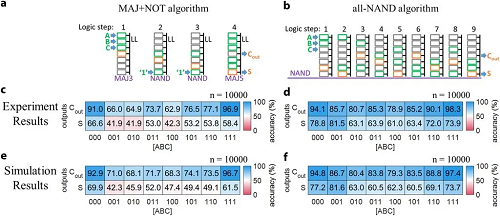

而 CRAM 新型存儲器通過將數據保存在存儲器內進行處理來解決這一問題,數據無需離開計算機存儲信息的網格,可以完全在內存陣列中進行處理。

團隊表示和傳統方法相比,基于 CRAM 的機器學習推理加速器能耗可降低至千分之一,甚至在某些場景應用下可以達到 1/1700 或者 1/2500。

該團隊成立于 2003 年,由物理學、材料科學、計算機科學和工程學專家組成,在過去 20 多年來一直開發該技術。

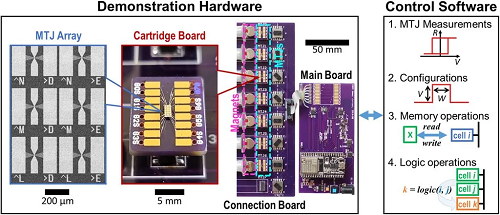

該研究以磁性隧道結(Magnetic Tunnel Junctions,MTJs)相關專利為基礎,而 MTJ 是硬盤、傳感器和其他微電子系統(包括磁隨機存取存儲器 MRAM)中使用的納米結構器件。

CRAM 架構克服了傳統馮-諾依曼架構(計算和內存是兩個獨立的實體)的瓶頸,能夠比傳統系統更有效地滿足各種人工智能算法的性能需求。

明尼蘇達大學團隊目前正與半導體行業的領導者合作,擴大演示規模,并生產必要的硬件,以更大規模地降低人工智能能耗。

本站內容除特別聲明的原創文章之外,轉載內容只為傳遞更多信息,并不代表本網站贊同其觀點。轉載的所有的文章、圖片、音/視頻文件等資料的版權歸版權所有權人所有。本站采用的非本站原創文章及圖片等內容無法一一聯系確認版權者。如涉及作品內容、版權和其它問題,請及時通過電子郵件或電話通知我們,以便迅速采取適當措施,避免給雙方造成不必要的經濟損失。聯系電話:010-82306118;郵箱:[email protected]。