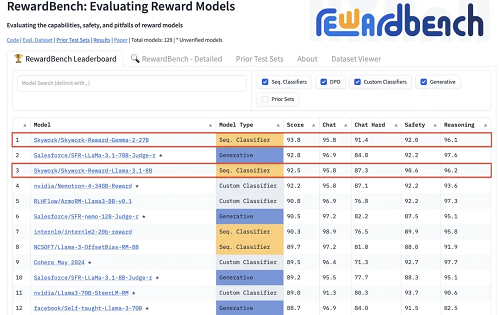

9 月 13 日消息,昆侖萬維發布了兩款全新的獎勵模型 Skywork-Reward-Gemma-2-27B 和 Skywork-Reward-Llama-3.1-8B。在獎勵模型評估基準 RewardBench 上,這兩款模型分別位列排行榜上的第一和第三位。

獎勵模型(Reward Model)是強化學習(Reinforcement Learning)中的核心概念和關鍵組成,它用于評估智能體在不同狀態下的表現,并為智能體提供獎勵信號以指導其學習過程,讓智能體能夠學習到在特定環境下如何做出最優選擇。

獎勵模型在大語言模型(Large Language Model,LLM)的訓練中尤為重要,可以幫助模型更好地理解和生成符合人類偏好的內容。

與現有獎勵模型不同,Skywork-Reward 的偏序數據僅來自網絡公開數據,采用特定的篩選策略,以獲得針對特定能力和知識領域的高質量的偏好數據集。

Skywork-Reward 偏序訓練數據集包含約 80,000 個樣本,通過在這些樣本上微調 Gemma-2-27B-it 和 Llama-3.1-8B-Instruct 基座模型,獲得最終的 Skywork-Reward 獎勵模型。

本站內容除特別聲明的原創文章之外,轉載內容只為傳遞更多信息,并不代表本網站贊同其觀點。轉載的所有的文章、圖片、音/視頻文件等資料的版權歸版權所有權人所有。本站采用的非本站原創文章及圖片等內容無法一一聯系確認版權者。如涉及作品內容、版權和其它問題,請及時通過電子郵件或電話通知我們,以便迅速采取適當措施,避免給雙方造成不必要的經濟損失。聯系電話:010-82306118;郵箱:[email protected]。